В августе 2014 года на сайт Bufferapp.com внезапно был наложен ручной штраф Google. После разъяснения ситуации выяснилось, что наказание применено по ошибке, из-за бага в работе поисковой системы. SEOnews рассмотрел этот и другие случаи, когда поисковик ошибался, наказывая сайты.

2011 — сайт indianguitartabs.com

В конце июля 2011 года из-за поисковика сайт indianguitartabs.com потерял в один день 66% трафика: количество посетителей упало с 15 000 до 5 000 уников.

Владелец сайта написал о проблеме на productforums.google.com и попросил консультации эксперта. В сообщении было сказано, что 2 месяцами ранее (в мае 2011года) сайт indianguitartabs.com переехал на движок VBulletin 4.x (раньше использовался 3.x), и стал применяться оптимизаторский плагин vbSEO. Кроме этого, на сайт был добавлен виджет Facebook. Это единственные изменения за те 8 лет, что существует сайт.

Владельцу indianguitartabs.com ответил представитель Google Пьер Фарр, который сказал, что информация о проблеме передана специалистам по поиску, и они уже нашли ошибку в алгоритме, негативно повлиявшую на позиции сайта. Пьер пообещал, что баг будет устранен в самое ближайшее время.

2012 — ошибка классификаторов припаркованных доменов

В апреле 2012 года в Google произошло массовое понижение позиции сайтов, в основном посвященных электронной коммерции. Версий насчет произошедшего было много, включая обновление фильтра Panda до версии 3.4.

стала ошибка в работе поисковой системы. Сбой привел к тому, что классификатор припаркованных доменов считывал не те файлы, в результате чего многие сайты были классифицированы, как размещенные на припаркованных доменах.

Мэтт Каттс на своей странице в Google+ лично извинился за инцидент и пообещал, что в ближайшее время рейтинг всех сайтов будет восстановлен. В дальнейшем, пообещал Мэтт, подобных ошибок специалисты Google постараются избежать.

2014 — Slashfilm.com и другие сайты о кино

24 февраля 2014 года о том, что на 8 зарубежных блогах о киноискусстве наблюдался резкий отток органического трафика. В число этих ресурсов попал и такой известный сайт, как Slashfilm.com. Утверждения о падении позиций сайтов подтвердились с помощью данных от SearchMetrics.

Как выяснилось позже, причиной падения послужил баг в алгоритме поисковой системы. Уже к концу февраля показатели трафика на пострадавших сайтах пошли вверх:

«Сохранить лицо» компании в очередной раз был вынужден Мэтт Каттс, который вновь охарактеризовал ситуацию, как «временную проблему», которая на момент его заявления была уже устранена. Один из блогеров со Slashfilm Питер Сциретта сказал, что трафик действительно полностью восстановился. Представители поисковой системы не стали никого посвящать в подробности случившегося.

2014 — Bufferapp.com

Отток органического трафика с 15 по 29 августа на сайте Bufferapp.com. Пост о том, что на сайт были наложены санкции Google, появился в официальном блоге ресурса. Штраф поисковой системы привел к падению трафика на 90%.

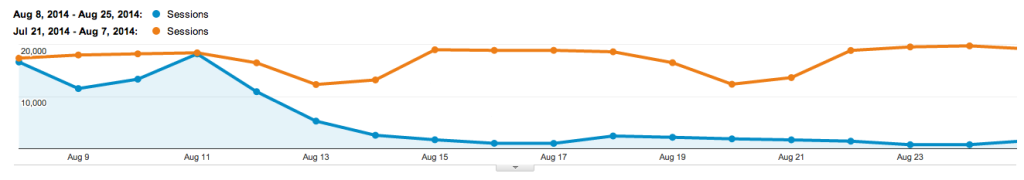

По словам представителя Bufferapp.com Кортни Ситер, когда Google объявил, что протокол HTTPS станет дополнительным преимуществом в ранжировании позиций сайта, Bufferapp перешел на использование этого протокола. Переход на HTTPS состоялся 8 августа 2014 года, вскоре после этого резко упал трафик. На графике оранжевая линия отображает посещаемость до перехода, синяя — после:

После падения трафика в адрес сайта пришло уведомление о ручном штрафе в Google Webmaster Tools. Представителям Bufferapp это показалось странным, поэтому ими был не только отправлен запрос в Google, но и нанят консультант по вопросам поисковой оптимизации для прояснения ситуации.

Эпопея с Bufferapp.com завершилась аналогичным образом — проблема оказалась в ошибке поисковой системы, все санкции с сайта были сняты и трафик восстановился. На графике ниже синяя черта отображает рост посещаемости Bufferapp.com в августе, после отмены наказания:

ДАЛЕЕ ОПРОС…

В данной публикации приведены несколько фактов, свидетельствующих о систематических багах в работе поисковых алгоритмов Google, из-за чего на сайты с кристально чистой репутацией попадали под фильтр. Как вы думаете, почему Google ошибается наказывая сайты?